Tiempo de lectura: 10 minutos

Si eres el CEO de una empresa, o un emprendedor que ha lanzado una startup, vete pensando en buscarte otra cosa. El plot twist que nadie vio venir del impacto de la Inteligencia Artificial en el empleo es que, en breve, ambos trabajos serán irrelevantes (preveo gran crisis en LinkedIn).

¿Cómo de breve?

A finales de 2023 se estimaba un horizonte de 2 años. No se si ahora que es finales de 2025 lo tenemos ya encima, pero debe estar ahí-ahí. La experiencia dice que invertir mucho dinero en poner a trabajar a personas muy inteligentes hará que ocurra antes o después.

¿Trabajando en qué?

En incorporar a la IA lo que los anglosajones llaman agency, término que aúna la capacidad de elegir qué acción tomar, tomarla y, por tanto, asumir las consecuencias.

Esta es la premisa de Mustafa Suleyman[1] que propone un nuevo Test de Turing. Originalmente [2], el Test de Turing habla de máquinas capaces de simular un comportamiento indistinguible del humano, en un juego que llamó “Imitation Game”. Básicamente el jugador, haciendo preguntas, debía adivinar si hablaba con un hombre o una mujer, y de ahí, si la máquina podría engañar al jugador para que no fuese capaz de distinguirla como tal. El fundador de DeepMind va más allá, propone saltar de la pregunta “¿pueden pensar las máquinas?”, a la pregunta “¿pueden las máquinas tener impacto relevante en el mundo?”.

¿Qué considera “impacto relevante”?

Pues que una IA sea capaz de hacer un estudio de mercado, identificar una necesidad compartida por un grupo de personas, encontrar una forma de satisfacerla, construirla, lanzarla y comercializarla, convirtiendo una inversión de 100.000 dólares en un resultado de 1 millón.

Vamos, el trabajo del CEO o el emprendedor.

¿Por qué alguien propondría que, de todas las cosas que puede hacer un ser humano (como educar a un niño, alimentar a un hambriento, atender a un enfermo, cobijar a un refugiado, descubrir una vacuna, etc.) lo realmente valioso sea mover millones de dólares?

Porque él lo hizo. Y porque puede. Porque le da la gana. La clave de ser un tecno-emprendedor de éxito es que puedes hacer lo que te dé la gana. Como por ejemplo:

Lo que te dé la p**a gana (Photo by ANGELA WEISS/AFP via Getty Images)

“Dato mata relato”

Es difícil rastrear el origen de la expresión “dato mata relato”, me gusta pensar que tiene sus raíces en Husserl [3], cuando dijo que “meras ciencias de hechos hacen meros seres humanos de hechos”.

Parece que las personas que trabajamos en tecnología hemos aceptado y después asimilado y por tanto incorporado la visión neopositivista [4] de Schlick, Carnap y el resto de los miembros del “Círculo de Viena”. Me resulta raro, porque el neopositivismo es una visión de la ciencia (conocer la realidad para poder explicarla), y diseñar, desarrollar y evolucionar AI es el dominio de la tecnología (transformar la realidad a través del conocimiento).

La concepción científica del mundo neopositivista introduce dos cambios que no hemos conseguido superar socialmente, y que están en el trasfondo de la crisis de valores que vivimos. En primer lugar, el empirismo, que consiste en admitir como cierto sólo aquello que se puede comprobar a través de la observación, y por tanto medir; y si se puede medir, puede convertirse en un dato de una Excel, y someterse a un algoritmo. Consecuencia de lo anterior, se propugna que la ciencia (que incluye matemáticas, física o lógica formal) es la fuente suprema de obtención de conocimiento. En segundo lugar, el neopositivismo se declara abiertamente contrario a la metafísica como disciplina capaz de explicar el mundo, y al pensamiento abstracto como forma de llegar a conclusiones verdaderas.

Y esta idea resulta muy interesante, porque si relegamos por debajo de la ciencia a la metafísica (por no ser una fuente aceptada de conocimiento) y la epistemología (por estar acotada al conocimiento que obtiene la ciencia) ¿dónde pondremos la ética? Por ejemplo, la pondremos debajo de la economía. Subordinada. He escuchado a personas decir en público que sus principios están vinculados al precio que pagan por tenerlos.

Esta pregunta está implícita en las críticas al neopositivismo. En su conferencia en Viena de 1935 [5], Husserl plantea que no todas las preguntas que se hace el hombre se pueden responder desde la ciencia; y que no hay que aceptar que, de entre todas las preguntas que se puede hacer el hombre, sean las más importantes justo aquellas que se pueden responder desde la ciencia. En su crítica, Husserl advierte la incapacidad de las disciplinas humanistas de defenderse frente al reduccionismo de lo medible, y por tanto del dato.

Dato mata relato.

Desde esa incapacidad surge esa crisis de valores que identificaba en la sociedad, inicialmente europea de los años 30, ampliable al mundo occidental en general hoy en día.

Los relatos míticos del siglo XXI

Husserl propone que la espiritualidad humana es un dominio de conocimiento ajeno al mundo de la ciencia, y por tanto no explicable desde la racionalidad de observaciones y datos. Aquí entrarían los valores, la moral, etc. “Dato mata relato” perpetúa el reduccionismo neopositivista, o sea, el reduccionismo de los valores. No se puede explicar la espiritualidad con una Excel. Lord Kelvin dijo que “lo que no se puede medir, no se puede mejorar”, y por desgracia nos lo hemos creído.

Sabemos que las sociedades humanas se articulan y unen en torno a relatos míticos, y que la historia nos demuestra que esos relatos los construyen personas con intereses. Pero claro, en el contexto en el que primero Husserl y luego Heidegger se movieron, el espíritu, como explicación del hombre, se vinculó a las identidades nacionales (el espíritu del individuo supeditado al espíritu de su nación), y los relatos que se construyen alrededor. Heidegger proponía como solución a la crisis del reduccionismo la recuperación de los relatos míticos clásicos [6], aunque el suyo por desgracia se vinculó a la identidad de la nación alemana, a partir de las ideas de Fichte, Schiller, Goethe y Hölderlin entre otros. Que luego utilizó el nacionalsocialismo para ascender al poder, y ya sabemos que eso acabó en Genocidio. En nuestros días, la invasión de Ucrania de 2022 sin ir más lejos se explica en las fuentes oficiales [7] con un relato que se retrotrae al Mito Fundacional Ruso, con San Vladimiro, Príncipe de Nóvgorod, Gran Príncipe de Kiev, y cristianizador de la Rus de Kiev en el siglo XI.

No os preocupéis, que hay relatos míticos y genocidios para todos

Normal que genere rechazo acudir a la narrativa Mítica para la creación de valores.

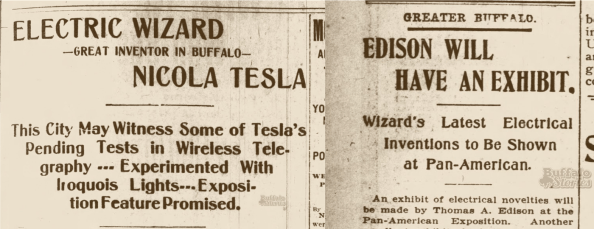

Una cosa interesante que no se si habrás pensando, es que las personas que creaban e imponía un relato mítico empezaron siendo los chamanes, y luego llegaron religiosos, militares, gobernantes, poetas, filósofos, intelectuales… Lo llamativo del siglo XXI es que surge un nuevo tipo de personas capaces de crear e imponer relatos míticos.

Empresarios y emprendedores.

¿Y qué relato mítico pueden crear?

Pues poder, podrían crear cualquiera.

Ya, pero ¿cuáles han creado?

Relatos en los que mitifican (su) capacidad para generar (su) riqueza o tomar (sus) decisiones. Se resumen en dos. Uno, el del hombre hecho a sí mismo que, empezando de la nada (o de la casi nada, según la pasta que le haya dado papi) consigue triunfar. Este relato ensalza el trabajo duro y el sacrificio y equipara “triunfo” y “riqueza”. El otro es el relato de “lo hago porque puedo”. Que no es la explicación de Trasímaco [8] cuando dice que lo justo es aquello que los poderosos imponen sobre los débiles. Sino más bien la línea del “Might is right” de Arthur Desmond [9]: que la razón (entendida como motivo) de hacer algo, es precisamente poder hacerlo. Algo reservado a los fuertes, audaces y ambiciosos. Que conducen un Lambo.

Salir del Mito

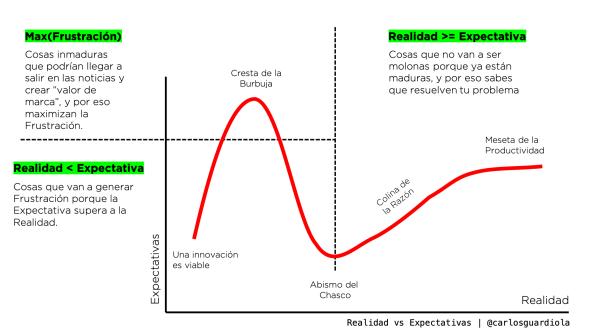

Lo que nos devuelve al origen de esta reflexión. A lo largo de sucesivas iteraciones, se ha impuesto un nuevo relato mítico: el de la tecnología que avanzará sin descanso hasta construir la Inteligencia Artificial que domine, supere y haga irrelevante al ser humano. De suerte que este relato técnico, se funde con el relato del empresario / emprendedor, que va a hacer que ocurra porque quiere o porque puede, y así nace la gran narrativa en la que estamos inmersos.

Es una lástima que nosotros los técnicos, inspirados sin saberlo por Husserl y Heidegger, hayamos creado un relato mítico que, desde lo técnico, va contra el espíritu del hombre, por la pasta, o por la audacia. Cerrando un círculo vicioso del relato técnico que neutraliza el relato de la espiritualidad.

Los líderes de la comunidad técnica necesitan abandonar este Mito, y aceptar otros que expliquen su propósito, relatos que nunca más deberían venir de aquellos que quieren transformar la realidad sólo si da dinero o alimenta su ego.

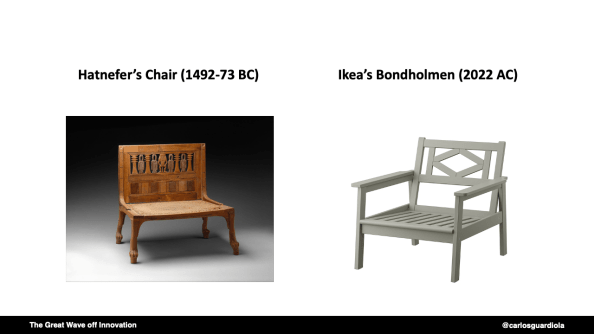

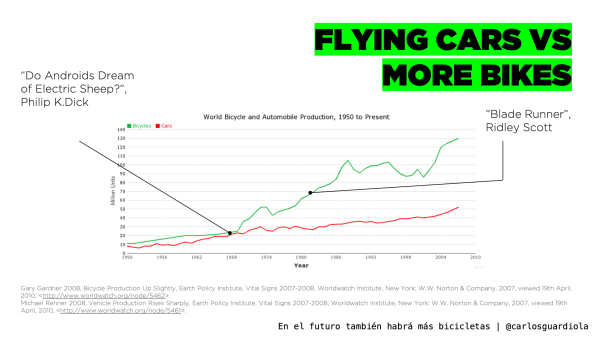

Debemos volver a los orígenes de la tecnología.

El relato mítico fundacional de la tecnología ya lo explicaba Protágoras [10]. El titán Prometeo robó las artes de Atenea (conocimiento) y Hefesto (tecnología), y con ellas el fuego (energía) sin el que no servirían para nada, y se las dio a los hombres para su progreso. No pudo robar la sabiduría política porque esa la custodiaba Zeus.

La ciencia, como fuente de conocimiento. La tecnología como transformación de la realidad a través del conocimiento. La transformación de la realidad para progresar hacia una sociedad mejor en los sentidos de libertad, igualdad, solidaridad, justicia, transparencia, sostenibilidad, inclusión…

En Europa por ejemplo hemos tenido que regular por Ley [11] que ese debe ser el propósito de la Inteligencia Artificial, para que a nadie le quede ninguna duda.

Pues todavía salen personas diciendo que esa Ley coarta y limita nuestra capacidad de innovación, ¡poniéndonos en desventaja!

¿Quién querría innovar sin respetar la libertad, la igualdad, la solidaridad…? ¿Cómo podría considerar el respeto de la libertad una desventaja? ¿Por qué no elegiría sumarse al relato Mítico de Europa como bloque donde se defiende la solidaridad? [12]

El relato Mítico de Europa

Jürgen Habermas tiene una visión interesante de qué significa Europa y en qué consiste ser europeo. Tuvo su epifanía en un día en particular, el 15 de febrero de 2003 cuando millones de personas marcharon contra la Guerra de Irak [13]. El francés Jacques Derrida compartió esta percepción y fue cosignatario de su manifiesto. Todas esas personas tenían en común precisamente ser europeos. Su conciencia colectiva despertó de manera global por encima de las fronteras de los países y sus gobiernos. El problema es que esa gente de la calle, esta esfera pública de la ciudadanía, no se trasladó a la acción política, ni en los gobiernos particulares, ni a nivel general, y hubo Guerra en Irak. Esta desconexión entre el ciudadano y el poder, que puede ser algo habitual en cualquier sistema político, es uno de los problemas esenciales que definen el hecho de ser europeo, porque se siente por partida doble. La desconexión con el gobierno de tu país, y desde ahí, la desconexión con el gobierno de Europa. Por ejemplo, en materia de regulación de la IA.

Si no se puede escuchar a Habermas, habrá que leerle. (Abisag Tüllman, BPK)

El déficit democrático persigue a Europa desde su (re)fundación en los años 50, y es algo en lo que deben trabajar los políticos, pero también debe ser responsabilidad de directivos y emprendedores. Que aquellos que tienen voz y representan a otros, trabajen en una Europa más fuerte. Esta fortaleza va más allá de buscar el equilibro entre importaciones y exportaciones en una Excel, pasa por alinear al ciudadano con su gobernante, materializar la auténtica unión política, y salir del papel de mercado de consumidores del que no nos quieren dejar salir Estados Unidos y China. Europa es mucho más que un gigantesco mercado de 740 millones de consumidores.

¿Cómo pasar del proyecto-mercado común al proyecto-político común? La visión de Habermas no se basa en desarrollar la identidad paneuropea desde la historia, pues pasaría por intentar unificar las características de diferentes naciones, que han estado en guerra entre sí desde la época clásica, siendo la Segunda Guerra Mundial la más horrible de todas ellas. Sino en articular la voluntad ciudadana que, tiene un proyecto hacia el futuro basado en ciertos principios y logros sociales compartidos. ¿Qué es lo que une a los europeos? ¿Qué cosa es la identidad de Europa?

Pues una serie de creencias. Los europeos creemos en la separación de poderes, incluyendo separar la religión del estado. También en la democracia participativa y el sufragio universal. En el estado del bienestar, que se funda en conceptos como el derecho a la educación y la asistencia sanitaria, las pensiones o los subsidios por desempleo. En el rechazo al uso de la fuerza para resolver los conflictos internacionales, en la tolerancia a otras ideas, y en el respeto a los derechos y libertades individuales [14]. Esta cultura política nos distingue esencialmente de otros modelos de sociedad como el ultraliberalismo estadounidense, el modelo de partido único chino, la cleptocracia rusa… por no hablar de los estados fallidos. Aunque estas creencias son culturales, devienen de situaciones históricas, como no puede ser de otra manera. Las guerras de religión nos enseñaron a separar el gobierno de la fe. La Ilustración y las Revoluciones, a separar el poder legislativo, del ejecutivo. El Holocausto, a poner el respeto a los derechos humanos por encima de todo. El Post-Colonialismo, a aceptar las visiones de otras identidades nacionales, y así.

Es posible que la AI Act no sea la mejor regulación en IA, y que pueda mejorarse y enmendarse, como todas las legislaciones, pero su redacción con principios como la transparencia y la explicabilidad, y su orientación al riesgo para las libertades individuales deberían ser un referente. ¿Por qué querría alguien no subirse al relato del paneuropeísmo?¿Por qué rechazarla sin haber entendido su propósito?

Porque el relato del emprendedor hecho a sí mismo, porque quiere y porque puede, mola más. Porque somos egoístas. Porque queremos ganar más dinero y conducir un lambo para poder subirlo a Instagram y que nos admiren.

Y porque hemos dejado fuera la ética y el humanismo en la formación a Directivos, Emprendedores y Técnicos.

Lo que está claro es que “dato mata relato” es en sí mismo un relato.

Jaque mate, dato.

Redux

Una versión más ligera de esta reflexión se publicó en la revista Ethic el 25 de marzo de 2024.

Referencias

[1] Suleiman, M. (2023), “The coming wave”, Crown.

[2] Turing, A. M. (1950), “Computing machinery and intelligence”, Mind 49:433-460

[3] Husserl, E. (2008), “La crisis de las ciencias europeas y la fenomenología trascendental”, Prometeo Libros

[4] Hans H. et al (1929), “The Scientific Conception of the World. The Vienna Circle”,, presentado en Tagung für Erkenntnislehre der exakten Wissenschaften

[5] Husserl, E. (1935), “Philosophy in the Crisis of European Mankind”, conferencia del 10 de mayo de 1935 en Viena.

[6] Habermas, J. (1977), “Martin Heidegger on the publication of lectures from year 1935”, Graduate Faculty Philosophy Journal 6 (2):155-180.

[7] Putin, V. (2021) “On the historical unity of Russians and Ukranians”, recuperado de http://www.en.kremlin.ru/events/president/news/66181

[8] Platón, (2013), “La República”, Alianza Editorial

[9] Redbeard, R. (2020), “Might is right. The survival of the fittest”, Forgotten Books

[10] Platón, (2015), “Protágoras / Gorgias / Carta Séptima”, Alianza Editorial

[11] 2021/0106 (COD), Proposal for a REGULATION OF THE EUROPEAN PARLIAMENT AND OF THE COUNCIL LAYING DOWN HARMONISED RULES ON ARTIFICIAL INTELLIGENCE (ARTIFICIAL INTELLIGENCE ACT) AND AMENDING CERTAIN UNION LEGISLATIVE ACTS

[12] Habermas, J. (2015), “The Lure of Technocracy. A Plea for more European solidarity”, Polity Press

[13] Habermas, J. y Derrida, J. (2003), “February 15, or What Binds Europeans Together”, Constellations Vol 10.

[14] Habermas, J. (2001), “Why Europe Needs a Constitution”, New Left Review 11.